Koristite zastareli preglednik. Možda se neće pravilno prikazivati ova ili druge veb stranice.

Trebalo bi da nadogradite ili koristite alternativni preglednik.

Trebalo bi da nadogradite ili koristite alternativni preglednik.

GeForce GTX 980 Thread

- Začetnik teme DoX

- Datum pokretanja

K e n z o

Slavan

- Učlanjen(a)

- 04.10.2012

- Poruke

- 1,574

- Poena

- 210

Nemam Redux... Da li vi ista podesavate u Nvidia Control Panel pod "Manage 3D settings" ili ostavljate sve na default? In jos nesto, stalno mi se pojavljuje u ovim testovima pored moje 980ke ova integrisana Standard VGA Graphics Adapter koju sam naravno iskljucio u BIOSu ali je opet tu...

Za NV Contol Panel, ovako treba da stoji, ovo je neki osnovni Tweak, a moze i dodatno da se podesava,

Ovo je za reprodukciju video materijala, tj. za bolju sliku, ( boje, kontrast itd)

Ovo je isto, za nesto bolju reprodukciju slike na monitoru i narocito kada se PC prikljuci na TV,

Ovo je DSR, tj. 2K i 4K rendovanje na 1080p monitorima i TV.

I, imas i onaj Nvidia Multi-Frame Anti- Aliasing (MFAA), za bolje performanse ali to je samo za odredjene igre.

Ovo je za reprodukciju video materijala, tj. za bolju sliku, ( boje, kontrast itd)

Ovo je isto, za nesto bolju reprodukciju slike na monitoru i narocito kada se PC prikljuci na TV,

Ovo je DSR, tj. 2K i 4K rendovanje na 1080p monitorima i TV.

I, imas i onaj Nvidia Multi-Frame Anti- Aliasing (MFAA), za bolje performanse ali to je samo za odredjene igre.

Ajd, postavi ove SS u "NVIDIA ForceWare - diskusija, pitanja, linkovi", ( ce nas izbace sa foruma):beat:

ima par stvari koje su, po meni, problematicno postavljene, pa da malo razmotrimo te stvari.:rtfm:

Inace, ako su ti ove postavke bile, i prilikom testiranja Ungine 4.0 testa, onda je to taj razlog, taj bug sto sam pominjao, koji uzrokuje onako mali score.:S:

ima par stvari koje su, po meni, problematicno postavljene, pa da malo razmotrimo te stvari.:rtfm:

Inace, ako su ti ove postavke bile, i prilikom testiranja Ungine 4.0 testa, onda je to taj razlog, taj bug sto sam pominjao, koji uzrokuje onako mali score.:S:

K e n z o

Slavan

- Učlanjen(a)

- 04.10.2012

- Poruke

- 1,574

- Poena

- 210

I ja sam pomislio na to, inace do sad sam uvijek isao na default postavke tj. nikad nista nisam dirao osim mozda "Single display performance mode" opcije i za PhysX na GPU i to je to. A sto se tice oc-a koji je najstabilniji bez offset voltaze? Pokusao bih sa +100MHz na core dok memoriju ne bih dirao + fan na auto.

P.S. necu se vise igrati sa ovim 3D Settings, na GTX780 je sve savrseno radilo i bez tweakovanja

I da! Evo vec 3-4 puta mi ovi najniviji driveri pucaju...

P.S. necu se vise igrati sa ovim 3D Settings, na GTX780 je sve savrseno radilo i bez tweakovanja

I da! Evo vec 3-4 puta mi ovi najniviji driveri pucaju...

Poslednja izmena:

Znaci, postavi ovako kako sam ti objasnio u mom postu, i "nista ne diraj" ako nisi siguran sta dobijas ili gubis sa odredjenim postavkama, http://www.tweakguides.com/NVFORCE_5.html.

A, za ovaj MFAA, imas objasnjeno u "NVIDIA ForceWare - diskusija, pitanja, linkovi" temi, vidi od mog posta #1981 i #1983, pa dalje.

Ajd, sad, resetuj NV Panel na default, pa uradi ponovo Ungine 4.0, mora sad da bude okey rezultat.

Odradi to prvo, pa cemo posle malo da "proanaliziramo":type: overklok.

A, za ovaj MFAA, imas objasnjeno u "NVIDIA ForceWare - diskusija, pitanja, linkovi" temi, vidi od mog posta #1981 i #1983, pa dalje.

Ajd, sad, resetuj NV Panel na default, pa uradi ponovo Ungine 4.0, mora sad da bude okey rezultat.

Odradi to prvo, pa cemo posle malo da "proanaliziramo":type: overklok.

Da, to je vec score, koji je u granicama "normale", sve je u redu sa karticom.

E, sad, overklok, pa, sve zavisi od temperatura same kartice.

U, principu, uvek se dobijaju bolje temperature sa custom postavkama ventova,

znaci, prvo, dodaj u MSI AF, za core clock +100MHz, Power Limit na maximum, memorija na default, i postavi neki custom profil za ventove,

i testiraj u Ungine 4.0, i obavezno pogledaj koje su temperature i boost klok i voltaza, preko OSD-a u MSI AF.

EDIT: By the way, deluje mi kao da nisi instalirao novi Windows kada si ubacio ovu G1, neki moj utisak je,:shock: da zbog toga imas ove bugove sa Driverima i integrisanom grafikom, kao da imas neke Windows Registry probleme.:cuss:

E, sad, overklok, pa, sve zavisi od temperatura same kartice.

U, principu, uvek se dobijaju bolje temperature sa custom postavkama ventova,

znaci, prvo, dodaj u MSI AF, za core clock +100MHz, Power Limit na maximum, memorija na default, i postavi neki custom profil za ventove,

i testiraj u Ungine 4.0, i obavezno pogledaj koje su temperature i boost klok i voltaza, preko OSD-a u MSI AF.

EDIT: By the way, deluje mi kao da nisi instalirao novi Windows kada si ubacio ovu G1, neki moj utisak je,:shock: da zbog toga imas ove bugove sa Driverima i integrisanom grafikom, kao da imas neke Windows Registry probleme.:cuss:

Poslednja izmena:

GoranM

Čuven

- Učlanjen(a)

- 15.12.2001

- Poruke

- 8,992

- Poena

- 945

Ovo je isto, za nesto bolju reprodukciju slike na monitoru i narocito kada se PC prikljuci na TV,

Pogledajte prilog 179612

Ovo naprosto nije tacno. "Clamp" ti ne dozvoljava da se koristi dalje od neke vrednosti (daljina u sceni), tj. treba ga drzati uvek na allow da bi imao sto ostrije texture i generalno dosta pomaze, ne u svim igrama ali pomaze, a posebno u OpenGL naslovima (mada ih je malo). Default je allow i treba ga tako ostaviti.

Poslednja izmena:

Da, delimicno si u pravu,ali, istina je negde uvek na sredini.

Postavio sam ovaj link sa detaljnim objasnjenjima,http://www.tweakguides.com/NVFORCE_7.html

Ja imam problem sa tim treperenjem tekstura, koje su bas izrazene,negde vise a negde manje,kada se postavi na "Allow", jer koristim ovaj 32" TV, pa je ovaj problem izrazeniji, tako da meni odgovara ova postavka,

A, imas mogucnost da i kroz ostale postavke kroz Panel, dodatno poboljsas AF.

U svakom slucaju, svako moze da proba i eksperimentise i da vidi, koje mu postavke najvise odgovaraju.

EDIT: Evo, neka lista tih OpenGL Games

https://en.wikipedia.org/wiki/List_of_OpenGL_programs

http://www.giantbomb.com/opengl/3015-5192/games/

Uf, bas dosta starije igre, pa, i ne mora da bude nesto preterano ostro, , bolje mi je, da mi teksture budu mirne i ciste.:,,:

, bolje mi je, da mi teksture budu mirne i ciste.:,,:

Postavio sam ovaj link sa detaljnim objasnjenjima,http://www.tweakguides.com/NVFORCE_7.html

Ja imam problem sa tim treperenjem tekstura, koje su bas izrazene,negde vise a negde manje,kada se postavi na "Allow", jer koristim ovaj 32" TV, pa je ovaj problem izrazeniji, tako da meni odgovara ova postavka,

A, imas mogucnost da i kroz ostale postavke kroz Panel, dodatno poboljsas AF.

U svakom slucaju, svako moze da proba i eksperimentise i da vidi, koje mu postavke najvise odgovaraju.

EDIT: Evo, neka lista tih OpenGL Games

https://en.wikipedia.org/wiki/List_of_OpenGL_programs

http://www.giantbomb.com/opengl/3015-5192/games/

Uf, bas dosta starije igre, pa, i ne mora da bude nesto preterano ostro,

Poslednja izmena:

Erik011

Slavan

- Učlanjen(a)

- 05.08.2012

- Poruke

- 3,452

- Poena

- 285

Pa realno kod Gigabyte GTX980 4GB GDDR5 Gaming G1 je naj brza frekfencija...u odnosu na ostale 980.

Sad one Titan imaju vise memorije,ali nije im veca frekfencija.

Sto se tice Nvidia grafickih karti.Tako da je ovo naj bolja kombinacija..povezana sa SLI po pitanju trajanja.Dzaba mnogo DRAM-a ,ako je GPU spor.

- Učlanjen(a)

- 09.11.2009

- Poruke

- 1,033

- Poena

- 199

Imam minitor Acer XB270H http://www.acer.rs/ac/sr/RS/content/model/UM.HB0EE.005 sa G-sync..nigde ne vidim opciju za ukljucivanje G-sync:

Prilozi

Poslednja izmena:

Dark_Messiah

Cenjen

- Učlanjen(a)

- 05.11.2011

- Poruke

- 971

- Poena

- 169

Imam minitor Acer XB270H http://www.acer.rs/ac/sr/RS/content/model/UM.HB0EE.005 sa G-sync..nigde ne vidim opciju za ukljucivanje G-sync:

Probaj sa drugim drajverom.

danilo989

Čuven

- Učlanjen(a)

- 31.10.2006

- Poruke

- 4,234

- Poena

- 735

Moja oprema

- CPU & Cooler

- AMD Ryzen 7 5800X3D, Scythe Fuma 2 rev. B Noctua NF-A12x25 Edition

- Matična ploča

- MSI MPG B550I Gaming Edge Wi-Fi ITX

- RAM

- 2x16GiB G.Skill TridentZ DDR4 3200Mb/s CL14 F4-3200C14D-32GTZKW

- GPU

- PowerColor Radeon RX 7800 XT Hellhound 16GiB Noctua NF-A12x25 Edition

- Storage

- Western Digital Black SN850 WDS100T1X0E-00AFY0 1TiB, Western Digital Blue 3D WDS200T2B0A 2TiB

- Zvuk

- Altec Lansing 220, HyperX Cloud II

- PSU

- Corsair SF750 Platinum 750W SFX

- Kućište

- Cooler Master NR200P ITX

- Monitor

- Dell G2724D 27" IPS 1440P 165Hz, ASUS VG259QM 25” IPS 1080P 240Hz

- Miš & tastatura

- Endgame Gear OP1 8K, HyperX Alloy Origins Aqua

- Ostale periferije

- APC BX1400U-GR

- Pristup internetu

- Kablovski internet

povezao sam graficku sa displayport,a Asus na DVI port

Ovde je problem. Treba DP-DP.

Edit: cek, cek, G-sync monitori nemaju DVI, kakav sad Asus kad si rekao Acer? Pobrkao si loncice.

Edit2: ako si povezao i Acer i Asus u dualmonitor mixed G-sync probaj sa 349.16 verzijom drajvera.

Poslednja izmena:

Dark_Messiah

Cenjen

- Učlanjen(a)

- 05.11.2011

- Poruke

- 971

- Poena

- 169

Ako je monitor iz potpisa on i nema G Sync.

danilo989

Čuven

- Učlanjen(a)

- 31.10.2006

- Poruke

- 4,234

- Poena

- 735

Moja oprema

- CPU & Cooler

- AMD Ryzen 7 5800X3D, Scythe Fuma 2 rev. B Noctua NF-A12x25 Edition

- Matična ploča

- MSI MPG B550I Gaming Edge Wi-Fi ITX

- RAM

- 2x16GiB G.Skill TridentZ DDR4 3200Mb/s CL14 F4-3200C14D-32GTZKW

- GPU

- PowerColor Radeon RX 7800 XT Hellhound 16GiB Noctua NF-A12x25 Edition

- Storage

- Western Digital Black SN850 WDS100T1X0E-00AFY0 1TiB, Western Digital Blue 3D WDS200T2B0A 2TiB

- Zvuk

- Altec Lansing 220, HyperX Cloud II

- PSU

- Corsair SF750 Platinum 750W SFX

- Kućište

- Cooler Master NR200P ITX

- Monitor

- Dell G2724D 27" IPS 1440P 165Hz, ASUS VG259QM 25” IPS 1080P 240Hz

- Miš & tastatura

- Endgame Gear OP1 8K, HyperX Alloy Origins Aqua

- Ostale periferije

- APC BX1400U-GR

- Pristup internetu

- Kablovski internet

Na slici u onom postu je Acer G-sync. Verovatno hoce g-sync + non-g-sync istovremeno.

- Učlanjen(a)

- 09.11.2009

- Poruke

- 1,033

- Poena

- 199

Sad sam instalirao 353.62 sa oficialnog sajta http://www.gigabyte.com/products/product-page.aspx?pid=5208#dl i opet se ne pojavljuhe u kontrol panelu od graficke ,a 355.82 drajver sam skinuo sa nvidia sajta koji odgovaraju za moju graficku i za moj OS.

Asus sam povezao na DVI,a Acer na Disolay port prvi po redu ostali Display portovi ne rade verovatno se ukljuce po potrebi.

Nvidia kaze da imam dobre drajvere:

Sta jos da pokusam?

Asus sam povezao na DVI,a Acer na Disolay port prvi po redu ostali Display portovi ne rade verovatno se ukljuce po potrebi.

Nvidia kaze da imam dobre drajvere:

Sta jos da pokusam?

Poslednja izmena:

Dark_Messiah

Cenjen

- Učlanjen(a)

- 05.11.2011

- Poruke

- 971

- Poena

- 169

Monitor koji poseduje G Sync mora biti primarni i to u full screen modu.

Takodje nisam siguran da G Sync radi u extended modu.

Raskaci taj jedan monitor i trebalo bi da ti radi G Sync.

Takodje nisam siguran da G Sync radi u extended modu.

Raskaci taj jedan monitor i trebalo bi da ti radi G Sync.

- Učlanjen(a)

- 09.11.2009

- Poruke

- 1,033

- Poena

- 199

Pokusao sam sad i to.ali i dalje nema G-Sync u CP.

Izgleda imaju dve verzije:

http://www.acer.rs/ac/sr/RS/content/model/UM.HB0EE.005

http://us.acer.com/ac/en/US/content/model/UM.HB0AA.A01

Jedna ima zvucnike a druga G-Sync.Izgleda da sam ja dobio ovu sa zvucnicima posto vidim da imaju zvucnici i rade preko Dispay porta.

Izgleda imaju dve verzije:

http://www.acer.rs/ac/sr/RS/content/model/UM.HB0EE.005

http://us.acer.com/ac/en/US/content/model/UM.HB0AA.A01

Jedna ima zvucnike a druga G-Sync.Izgleda da sam ja dobio ovu sa zvucnicima posto vidim da imaju zvucnici i rade preko Dispay porta.

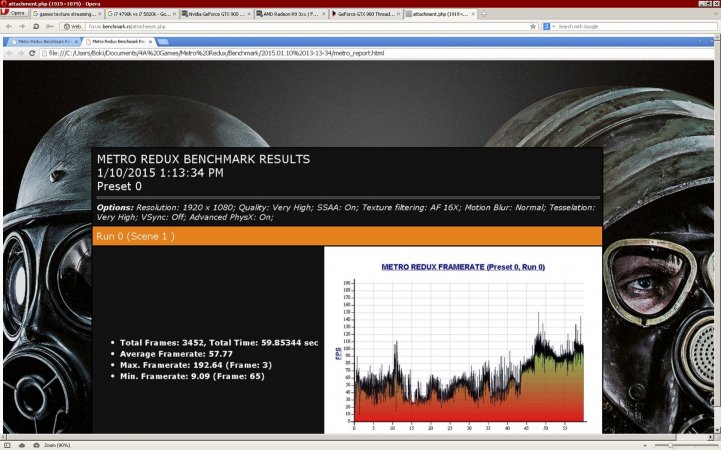

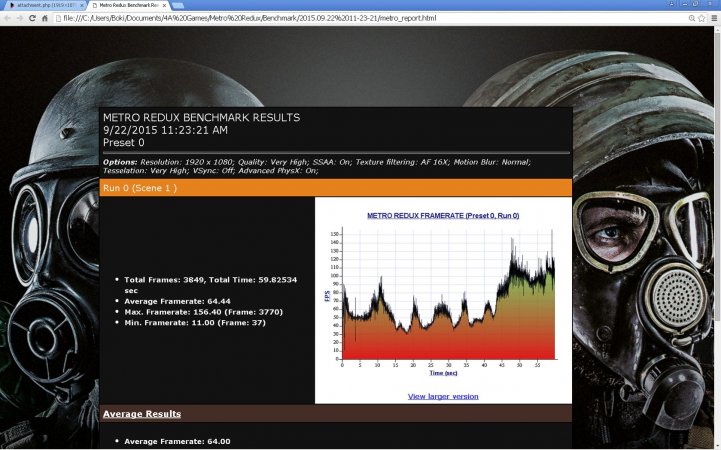

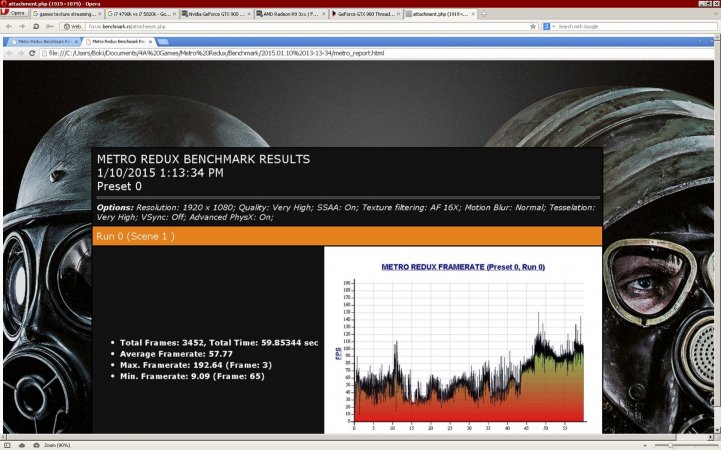

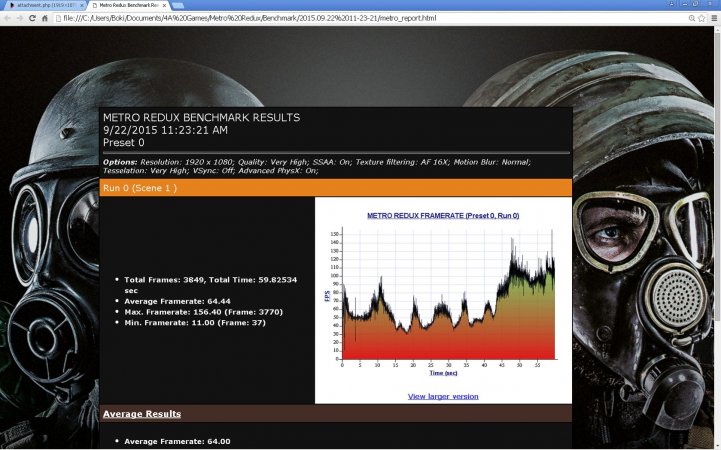

Evo, ovako, neki testovi dve razlicite konfiguracije:

Prva: I5 3570K na 4.6 Ghz, Ram 2X4GB na 2.000 Mhz, i MSI 980 na 1.590|7950 MHz kloku.

Druga: I7 4790K na 4.9 Ghz, Ram 2X4GB na 2.400 Mhz, i MSI 980 na 1.590|7950 MHz kloku. I7 sljaka bez HT.

Levo je Prva, a desno je Druga konfiguracija:

Batman Origins:

Metro 2033 Redux:

Dakle, vidi se porast performansi :

Batman Origins za negde oko 12% za minimum fps i oko 8% za maximum fps

Metro 2033 Reux za negde oko 12% za average fps, minimum je nepouzdan u merenju.

Znaci, ipak ima kod odredjenih igara bas solidan porast u performansama kod overkloka procesora i memorije.

Kasnije cu dodati jos neki test.

Prva: I5 3570K na 4.6 Ghz, Ram 2X4GB na 2.000 Mhz, i MSI 980 na 1.590|7950 MHz kloku.

Druga: I7 4790K na 4.9 Ghz, Ram 2X4GB na 2.400 Mhz, i MSI 980 na 1.590|7950 MHz kloku. I7 sljaka bez HT.

Levo je Prva, a desno je Druga konfiguracija:

Batman Origins:

Metro 2033 Redux:

Dakle, vidi se porast performansi :

Batman Origins za negde oko 12% za minimum fps i oko 8% za maximum fps

Metro 2033 Reux za negde oko 12% za average fps, minimum je nepouzdan u merenju.

Znaci, ipak ima kod odredjenih igara bas solidan porast u performansama kod overkloka procesora i memorije.

Kasnije cu dodati jos neki test.

Poslednja izmena:

Znaci, isto testiranje sa dve machine:

Levo Prva, a desno druga konfa:

Tomb Raider 2013:

Middle-earth: Shadow of Mordor:

Dakle, za Tomb 2013, prakticno nema dobitaka, igrica je bas GPU zahtevna i moze da radi na solidnom CPU procu.

Middle-earth: Shadow of Mordor, ima neki mali dobitak na avrg. fps od oko 4%, a za minimum je situacija, da je vrlo nestabilan u pokazivanju fps-a, moze ide od minimum 65f. do nekih 90fps, ali ipak pokazuje neki porast u odnosu na minimum kod Prve konfiguracije od 58fps. U svakom slucaju ima neki porast performansi i kod minumum fps-a.

Nazalost, nemam vise testova sa onom starom I5 3570K konfiguracijom, pa ne mogu da odradim jos poredjenja, ali u svakom slucaju ima napretka u performansama pri jacem procesoru ( IPC instruction proca) i vecem overkloku procesora i memorije.

Naravno, najvise zavisi od same igre koliki ce biti dobici u jacini, ali u principu, gde zafali neke procesorske snage, kao sto su MP, Strateske i slicne igre, kao i CPU bound igrice, videce se razlika.

Imaju oni na onom Poljskom sajtu dosta testova gde se vidi razlika u performansama odredjenih procesora, imaju oni neki svoj nacin testiranja PC komponenata, i vrlo je interesantno to pogledati,

u sustini, sve se svodi na to, kada se u gamingu dogadjaju neke intezivne( akcija) i komlikovanije( graficki) scene, tad dolazi do situacije,da jacina i performanse nekog procesora mogu doneti bolji i stabilniji framerate.

Levo Prva, a desno druga konfa:

Tomb Raider 2013:

Middle-earth: Shadow of Mordor:

Dakle, za Tomb 2013, prakticno nema dobitaka, igrica je bas GPU zahtevna i moze da radi na solidnom CPU procu.

Middle-earth: Shadow of Mordor, ima neki mali dobitak na avrg. fps od oko 4%, a za minimum je situacija, da je vrlo nestabilan u pokazivanju fps-a, moze ide od minimum 65f. do nekih 90fps, ali ipak pokazuje neki porast u odnosu na minimum kod Prve konfiguracije od 58fps. U svakom slucaju ima neki porast performansi i kod minumum fps-a.

Nazalost, nemam vise testova sa onom starom I5 3570K konfiguracijom, pa ne mogu da odradim jos poredjenja, ali u svakom slucaju ima napretka u performansama pri jacem procesoru ( IPC instruction proca) i vecem overkloku procesora i memorije.

Naravno, najvise zavisi od same igre koliki ce biti dobici u jacini, ali u principu, gde zafali neke procesorske snage, kao sto su MP, Strateske i slicne igre, kao i CPU bound igrice, videce se razlika.

Imaju oni na onom Poljskom sajtu dosta testova gde se vidi razlika u performansama odredjenih procesora, imaju oni neki svoj nacin testiranja PC komponenata, i vrlo je interesantno to pogledati,

u sustini, sve se svodi na to, kada se u gamingu dogadjaju neke intezivne( akcija) i komlikovanije( graficki) scene, tad dolazi do situacije,da jacina i performanse nekog procesora mogu doneti bolji i stabilniji framerate.

Poslednja izmena:

Postavlja se jedno legitimno pitanje,:laugh:

ako postoji razlika izmedju raznih proceva, u broju postignutog Framerata, pri testiranju raznih grafika , pogotovo tipa TitanX i 980Ti, FuryX i Fury, kao i 980 i 970, pogotovo kada se overklokuju,

koji je pravi izbor nekog CPU za gaming, koje je( pitanje) bas kljucno, jer, ako se kupuju ovako jake grafe, mora i ostatak komponenti, prvenstveno procesori i memorija, da isprate takvu GPU snagu i da poteraju te grafe u fullu.

Takodje, mislim da je i veoma upitno:trust:, kada razni sajtovi, kada testiraju grafike, ne koriste najbolje i najjace proceve i memorije, koji trenutno postoje.

Evo, https://www.techpowerup.com/reviews/AMD/R9_Nano/5.html,

koristi za test, i7-4770K @ 4.2 GHz i Ram od 1600 MHz, a testiraju se neke "besne" 980Ti karte.

Po ovim testovima sto sam postavio, I7 4790K na 4.9gzh i ram na 2.400mhz, bi sigurno dali bolje i realnije rezultate tih kartica, od ovih komponenti koristenih na Techpowerup sajtu.. Ma, i taj i7-4770K, kad bi se poterao na 4.9ghz , dao bi bolje rezultate.

Evo, Guru3D i KitGuru koriste i7 5960X i memoriju na oko 2.500mhz za testove, tako da se te strane, imaju maximalnu mogucu procesorsku snagu, da mogu da potpuno iskoriste grafe u fullu.

Gde je tu problem ?

Pa,

prvo, ako sa ovim i7-4770K na 4.2ghz mozes da pokrenes u fullu, recimo, neku grafu tipa 280X ili 770, a ne mozes da dobijes neki maximalni fps za neku custom 980Ti, onda ce, automatski znaciti, da se ne dobija realna razlika u fps i jacini, izmedju 980Ti i 280X karte, kao kad bi se, na primer, koristio neki i7 5960X da potera ovu 980Ti u fullu, na nekom maximalnom frameratu, koji ova kartica moze da postigne.

I, takodje, postavlja se pitanje, cije kartice bolje skaliraju, da li od AMD ili Nvidia, kad se koristi bolji i jaci proc, sa vecim klokom( i takodje ako je brza memorija), i koliko ce dobiti bolji fps u zavisnosti od ovih parametara....

ako postoji razlika izmedju raznih proceva, u broju postignutog Framerata, pri testiranju raznih grafika , pogotovo tipa TitanX i 980Ti, FuryX i Fury, kao i 980 i 970, pogotovo kada se overklokuju,

koji je pravi izbor nekog CPU za gaming, koje je( pitanje) bas kljucno, jer, ako se kupuju ovako jake grafe, mora i ostatak komponenti, prvenstveno procesori i memorija, da isprate takvu GPU snagu i da poteraju te grafe u fullu.

Takodje, mislim da je i veoma upitno:trust:, kada razni sajtovi, kada testiraju grafike, ne koriste najbolje i najjace proceve i memorije, koji trenutno postoje.

Evo, https://www.techpowerup.com/reviews/AMD/R9_Nano/5.html,

koristi za test, i7-4770K @ 4.2 GHz i Ram od 1600 MHz, a testiraju se neke "besne" 980Ti karte.

Po ovim testovima sto sam postavio, I7 4790K na 4.9gzh i ram na 2.400mhz, bi sigurno dali bolje i realnije rezultate tih kartica, od ovih komponenti koristenih na Techpowerup sajtu.. Ma, i taj i7-4770K, kad bi se poterao na 4.9ghz , dao bi bolje rezultate.

Evo, Guru3D i KitGuru koriste i7 5960X i memoriju na oko 2.500mhz za testove, tako da se te strane, imaju maximalnu mogucu procesorsku snagu, da mogu da potpuno iskoriste grafe u fullu.

Gde je tu problem ?

Pa,

prvo, ako sa ovim i7-4770K na 4.2ghz mozes da pokrenes u fullu, recimo, neku grafu tipa 280X ili 770, a ne mozes da dobijes neki maximalni fps za neku custom 980Ti, onda ce, automatski znaciti, da se ne dobija realna razlika u fps i jacini, izmedju 980Ti i 280X karte, kao kad bi se, na primer, koristio neki i7 5960X da potera ovu 980Ti u fullu, na nekom maximalnom frameratu, koji ova kartica moze da postigne.

I, takodje, postavlja se pitanje, cije kartice bolje skaliraju, da li od AMD ili Nvidia, kad se koristi bolji i jaci proc, sa vecim klokom( i takodje ako je brza memorija), i koliko ce dobiti bolji fps u zavisnosti od ovih parametara....

Poslednja izmena:

Evo, nesto sa sajtova.

Rusi i Poljaci, sta ces, nekadasnji Istocni blok.:test:

Test za gtz 980:

Dakle, vidi se, ,)

koliko je neophodan neki procesor, tipa i7 5960X, da bi grafiku kao sto je gtx 980, poterao u nekim maximalnim brojem frejmova, u ovim odredjenim igrama, i to kada, svi ovi Intelovi procesori, rade na priblizno istom kloku.

Na ovim drugim testovima, moze se videti, koliko overklok procesora utice na broj frejmova pri testu iste kartice u istoj igrici.

Dakle, po svemu sudeci, :laugh:

moze postojati, odredjena razlika u broju frejmova, kada se koriste procesori razlicitih jacina i razlicitog overkloka, zajedno sa nekom brzom memorijom( uslovno).

Sad, samo je pitanje isplativosti takve, konfiguracije.

Sto se tice odnosa cene i performansi, naravno, jasno je da je apsolutno neisplativo.

Za jedan i7 5960X, dati toliko vise love, da bi imao, otprilike oko 10-15% bolje performanse, u nekim odredjim igrama, sa jednom gtx 980Ti, je neisplativo, u odnosu koliko je dato manje love za neki drugi proc.

Naravno, za profesionalne sajtove, koji ozbiljno testiraju grafe i bave se gamingom, apsolutno je neophodan, jedan od najjacih proceva koji postoje na trzistu, da bi se dobili realni rezultati u testiranju grafickih kartica.

Rusi i Poljaci, sta ces, nekadasnji Istocni blok.:test:

Test za gtz 980:

Dakle, vidi se, ,)

koliko je neophodan neki procesor, tipa i7 5960X, da bi grafiku kao sto je gtx 980, poterao u nekim maximalnim brojem frejmova, u ovim odredjenim igrama, i to kada, svi ovi Intelovi procesori, rade na priblizno istom kloku.

Na ovim drugim testovima, moze se videti, koliko overklok procesora utice na broj frejmova pri testu iste kartice u istoj igrici.

Dakle, po svemu sudeci, :laugh:

moze postojati, odredjena razlika u broju frejmova, kada se koriste procesori razlicitih jacina i razlicitog overkloka, zajedno sa nekom brzom memorijom( uslovno).

Sad, samo je pitanje isplativosti takve, konfiguracije.

Sto se tice odnosa cene i performansi, naravno, jasno je da je apsolutno neisplativo.

Za jedan i7 5960X, dati toliko vise love, da bi imao, otprilike oko 10-15% bolje performanse, u nekim odredjim igrama, sa jednom gtx 980Ti, je neisplativo, u odnosu koliko je dato manje love za neki drugi proc.

Naravno, za profesionalne sajtove, koji ozbiljno testiraju grafe i bave se gamingom, apsolutno je neophodan, jedan od najjacih proceva koji postoje na trzistu, da bi se dobili realni rezultati u testiranju grafickih kartica.

Poslednja izmena:

Hmm, http://www.bug.hr/vijesti/nvidia-stavlja-desktop-verziju-gtx-980-laptope/146718.aspx,

kako ce to cudo da se "oladi", pa to je onda neka Nano Gtx 980 u laptope.:beat:

https://www.youtube.com/watch?v=DJeXUKFvcHs

kako ce to cudo da se "oladi", pa to je onda neka Nano Gtx 980 u laptope.:beat:

https://www.youtube.com/watch?v=DJeXUKFvcHs

Evo, odmah cu da dam jedan primer, kada su prilikom testiranja igara koristecene, blago receno , drugacije rute tih "putanja".

, drugacije rute tih "putanja".

Evo, ja mogu reci, na osnovu mog iskustva u nekom svom testiranju gtx 980 i gtx 780 kartica, da je onaj Hardware Canucks sajt, malo pristrastan na stranu AMD u odnosu na Nvidia, kada su u pitanju rezultati grafickih kartica.

To je moje misljenje, sad, da li ima u tome neka losa namera, ili je jednostavno u pitanju odabir tih nekih "putanja" u testiranju, pitanje je na mestu, ali...

Evo, mali primer.

Mislim, ako se bavis testiranjem grafickih kartica, onda i pre nego sto pocnes sa testom, moras, bar otprilike da si upoznat sa snagom svake pojedinacne kartice, tj. da znas otprilike, koliko je koja kartica jaca od neke druge i takodje, sto je po meni isto vrlo bitno, da znas, kojoj kartici( tj. kojoj arhikteturi), odgovara koja igra.

Zasto je to bitno ?

Pa, jednostavno, da ako u nekom odredjenom slucaju, dobijes neke rezultate u testovima koji ne odgovaraju bas tim nekim odnosima i predvidjanjima koje si imao u glavi pre testiranja zadatih kartica,

onda znas da ima nekih problema prilikom testirnja kartica, pa ces da ili ponovis test ili ces da naglasis da ima nekih nejasnoca u rezultatima za taj odredjeni test.

Evo, samo mali primer.

http://www.hardwarecanucks.com/forum/hardware-canucks-reviews/70321-asus-r9-fury-strix-review-11.html

http://www.guru3d.com/articles_pages/amd_radeon_r9_nano_review,20.html

Po ovim sajtovima, isto setovanje grafike, ali potpuno razliciti rezultati.

Posto imam tu gtx 980 i znam koliko otprilike moze da pruzi u odredjenim igrama, i znam koliko je jaca od AMD 290X kartice, odmah na prvu loptu, sam primetio da je u ovom testu na Hardware Canucks sajtu, u Witcher 3, na 2K rezoluciji,

ima, bulvalno isti fps kao i 290X, sto je apsolutno nemoguce .

.

I, ako se pogledaju, bukvalno svi testovi koji postoje na net-u, videce se, da bez obzira kako postavili graficka podesavanja u igri, nema sanse da 980 bude jednaka sa 290X u ovoj igrici, cak, je i 980 dosta jaca po broju frejmova u odnosu na 290X...

I, da odmah odgovorim,:laugh:, ima veze sa temom,:rtfm:, prica se o gtx 980 kartici.

Naravno, ima sigurno primera i u drugom smeru.:smoke:

Evo, ja mogu reci, na osnovu mog iskustva u nekom svom testiranju gtx 980 i gtx 780 kartica, da je onaj Hardware Canucks sajt, malo pristrastan na stranu AMD u odnosu na Nvidia, kada su u pitanju rezultati grafickih kartica.

To je moje misljenje, sad, da li ima u tome neka losa namera, ili je jednostavno u pitanju odabir tih nekih "putanja" u testiranju, pitanje je na mestu, ali...

Evo, mali primer.

Mislim, ako se bavis testiranjem grafickih kartica, onda i pre nego sto pocnes sa testom, moras, bar otprilike da si upoznat sa snagom svake pojedinacne kartice, tj. da znas otprilike, koliko je koja kartica jaca od neke druge i takodje, sto je po meni isto vrlo bitno, da znas, kojoj kartici( tj. kojoj arhikteturi), odgovara koja igra.

Zasto je to bitno ?

Pa, jednostavno, da ako u nekom odredjenom slucaju, dobijes neke rezultate u testovima koji ne odgovaraju bas tim nekim odnosima i predvidjanjima koje si imao u glavi pre testiranja zadatih kartica,

onda znas da ima nekih problema prilikom testirnja kartica, pa ces da ili ponovis test ili ces da naglasis da ima nekih nejasnoca u rezultatima za taj odredjeni test.

Evo, samo mali primer.

http://www.hardwarecanucks.com/forum/hardware-canucks-reviews/70321-asus-r9-fury-strix-review-11.html

http://www.guru3d.com/articles_pages/amd_radeon_r9_nano_review,20.html

Po ovim sajtovima, isto setovanje grafike, ali potpuno razliciti rezultati.

Posto imam tu gtx 980 i znam koliko otprilike moze da pruzi u odredjenim igrama, i znam koliko je jaca od AMD 290X kartice, odmah na prvu loptu, sam primetio da je u ovom testu na Hardware Canucks sajtu, u Witcher 3, na 2K rezoluciji,

ima, bulvalno isti fps kao i 290X, sto je apsolutno nemoguce

I, ako se pogledaju, bukvalno svi testovi koji postoje na net-u, videce se, da bez obzira kako postavili graficka podesavanja u igri, nema sanse da 980 bude jednaka sa 290X u ovoj igrici, cak, je i 980 dosta jaca po broju frejmova u odnosu na 290X...

I, da odmah odgovorim,:laugh:, ima veze sa temom,:rtfm:, prica se o gtx 980 kartici.

Naravno, ima sigurno primera i u drugom smeru.:smoke:

Slash

Slavan

- Učlanjen(a)

- 15.02.2013

- Poruke

- 1,066

- Poena

- 225

Moja oprema

- CPU & Cooler

- AMD Ryzen 7 9800X3D + Noctua NH-D15 Chromax w/ 3xNF-A15 Chromax

- Matična ploča

- Asus TUF Gaming X670E-Plus

- RAM

- 32GB G.Skill Flare X5 6000MHz CL28

- GPU

- Zotac RTX 4080 Trinity 16GB GDDR6X

- Storage

- Kingston Fury Renegade NVMe 1TB + 24TB

- Zvuk

- Realtek ALC1220A

- PSU

- Super Flower Leadex 1000W Platinum

- Kućište

- Asus ProArt PA602 + 4x NF-P14s Redux

- Monitor

- G80SD 32" 4K QD-OLED & S90D 65" 4K QD-OLED

- Miš & tastatura

- Corsair K95 Platinum + Razer DeathAdder Essential

- Ostale periferije

- PlayStation 5 Pro

- Laptop

- HP 250 G8

- Mobilni telefon

- Samsung S24 Ultra 12/256GB

- Pametni uređaji

- DJI Mini 5 Pro with RC2 & DJI Osmo Action 5 Pro

- Pristup internetu

- Optički internet

Briget?

Koje drajvere koristis?

Koje drajvere koristis?

Preporučite:

Instalacija aplikacije

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Napomena: this_feature_currently_requires_accessing_site_using_safari