pixell

Slavan

- Učlanjen(a)

- 01.02.2006

- Poruke

- 2,436

- Poena

- 380

...Temu je koliko vidim otvorio jedan od ovde poznatih ATI fanova, tako da ako je neko sadio flame-seed to je on.

Hvala što si me nazvao ATI fan-om a ne fanboy-em

I da, naginjem na AMD stranu trenutno, baš kao što sam u vreme nVidijinih serija 6000 i 8000 naginjao na nV stranu. Jednostavno ću podržavati onu stranu koja radi više za mene, kao krajnjeg korisnika.

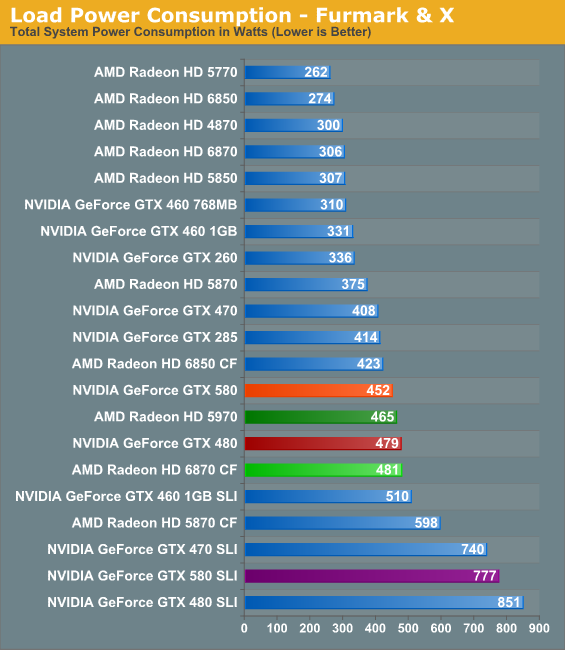

U svim testovima koji su izasli GTX 580 ima od 10-25% vece performance od GTX 480,u nekim igrama i manje od 10%, ali nikada nije sporiji. Zakljucak je da se nVidia-ino dinamicko regulisanje voltaze i klokova ne ukljucuje ni u jednoj igri. U istim tim igrama, u 95% testova GTX 580 pokazuje 20-30W manju potrosnju, u ostalih 5% testova pokazuje istu ili za par vati vecu potrosnju.

Dakle, GTX 580 daje performace boost u odnosu na GTX 480 onoliki koliki je ocekivan zbog povisenih klokova i CC-ova a za to vreme vuce manje struje. I sta sad tu ima da se doda?

To sam i ja rekao u prvom postu. Nema sumnje da je GF110 daleko bolja kartica od GF100.

Jel se desilo na nekom testu da overclockovani GTX 580 ima znatan par performansi? Ja sam samo video lepo skaliranje na gore sa clockom i nista vise

Gde je to W1zzard pokazao da GTX 580 pod Furmarkom(kad se iskljuci dinamicko regulisanje kloka) trosi vise od GTX-a 480??

Prvo si poceo sa W1zzard-ovim citatima i onda vesto ubacio grafikone sa Fudzille...nice..

Nisi ni pogledao TechPowerUp forum.

Evo recimo sta kaze Anand:

Pa onda Vr-Zone:

EDIT: I Anandov i VRZone review su stariji dva odnosno četiri dana od ovog "fiksa"

Slažem se ja sa time, ali pogledaj naziv teme. Jasno sam u prvom postu stavio u intenzivnim stress test aplikacijama da neko ne bi pomislio da se odnosi i na igre...

Poslednja izmena: