pixell

Slavan

- Učlanjen(a)

- 01.02.2006

- Poruke

- 2,436

- Poena

- 380

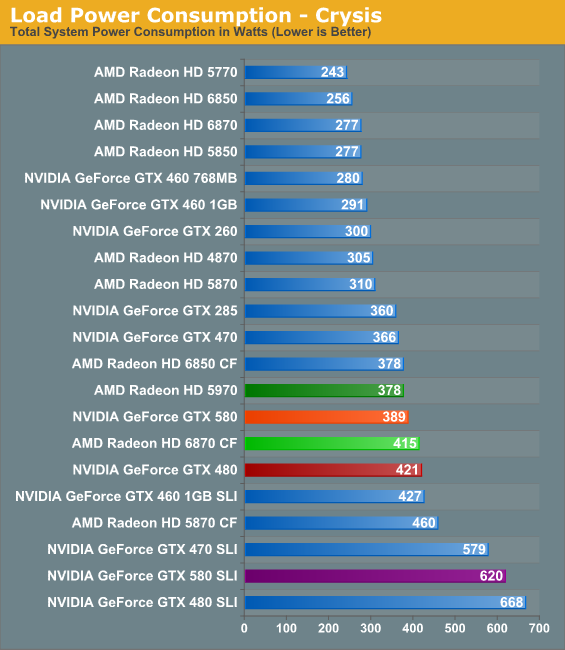

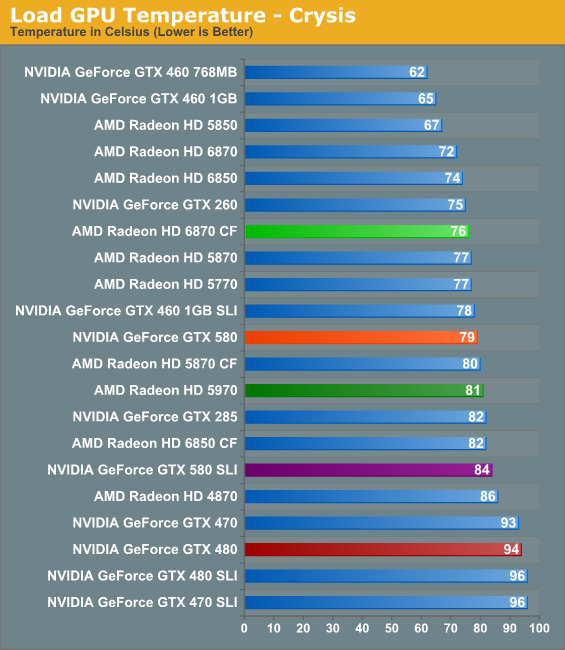

Prilikom inicijalnog predstavljanja GTX580 kartice nVidija je, pored performansi, najveći akcenat stavila na kvalitet coolera i potrošnju, upoređivaći GTX580 sa prethodnim modelima iz svoje ne tako davne prošlosti.

Iako smo imali prilike da se uverimo u odličan kvalitet vapor - chamber coolera, mnogima je ostalo nejasno smanjenje potrošnje u odnosu na GTX480 i pored povećanja broja Cuda cores-a i frekvencija za gotovo 10%.

Izgleda da je dinamičko podešavanje performansi zaduženo za to:

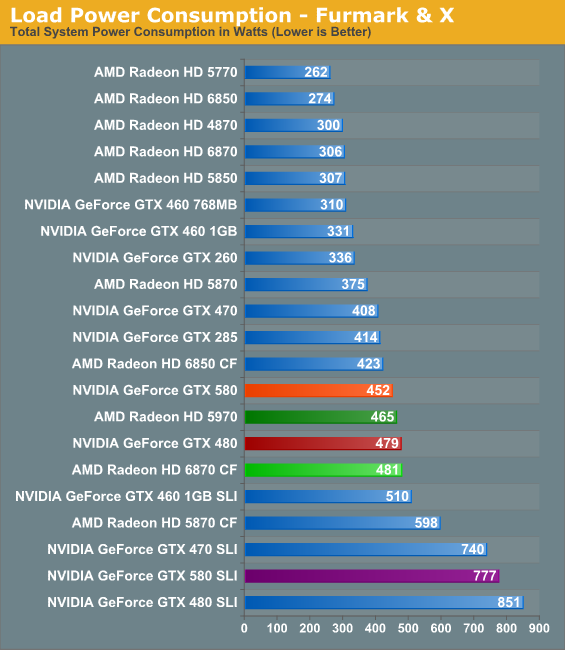

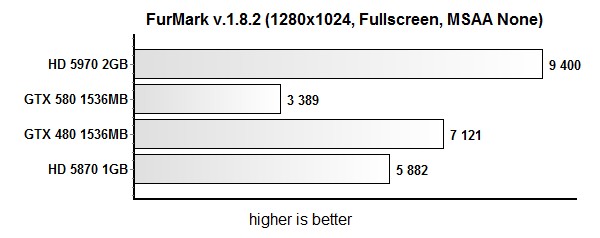

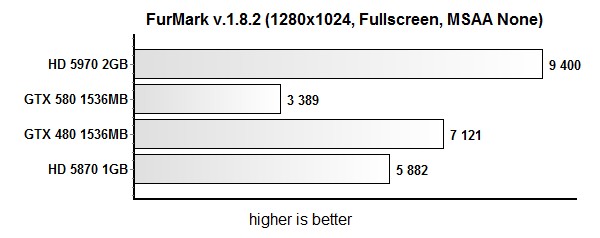

Naime, nakon W1zzard-ovog uputstva za uklanjanje ove "zaštite" dolazi se do zaključka da GTX580 (aka GF110) ipak više troši od GTX480 (GF100) u intenzivnim stress test aplikacijama:

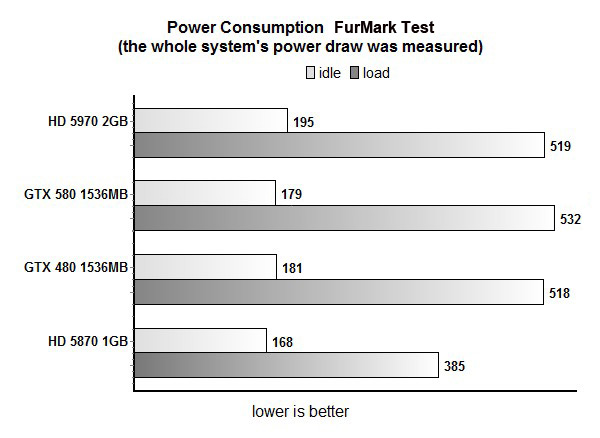

Protection enabled:

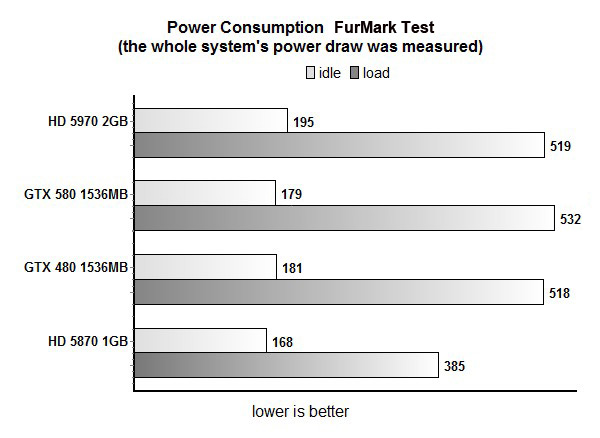

Protection disabled:

Na optimizaciji potrošnje se neminovno radilo ali nije sve tako ružičasto kao što se predstavlja.

Iako će se ovaj ili sličan vid eksploatacije kartica verovatno retko koristiti (HPC? CUDA programming?) ipak je dobro videti kako nVidia PR ume da ubedi narod da je "usual power consumption" isto što i TDP

Iako smo imali prilike da se uverimo u odličan kvalitet vapor - chamber coolera, mnogima je ostalo nejasno smanjenje potrošnje u odnosu na GTX480 i pored povećanja broja Cuda cores-a i frekvencija za gotovo 10%.

Izgleda da je dinamičko podešavanje performansi zaduženo za to:

Naime, nakon W1zzard-ovog uputstva za uklanjanje ove "zaštite" dolazi se do zaključka da GTX580 (aka GF110) ipak više troši od GTX480 (GF100) u intenzivnim stress test aplikacijama:

W1zzard

In order to stay within the 300 W power limit, NVIDIA has added a power draw limitation system to their card. When either Furmark or OCCT are detected running by the driver, three sensors measure the inrush current and voltage on all 12 V lines (PCI-E slot, 6-pin, 8-pin) to calculate power. As soon as the power draw exceeds a predefined limit, the card will automatically clock down and restore clocks as soon as the overcurrent situation has gone away. NVIDIA emphasizes this is to avoid damage to cards or motherboards from these stress testing applications and claims that in normal games and applications such an overload will not happen. At this time the limiter is only engaged when the driver detects Furmark / OCCT, it is not enabled during normal gaming. NVIDIA also explained that this is just a work in progress with more changes to come. From my own testing I can confirm that the limiter only engaged in Furmark and OCCT and not in other games I tested. I am still concerned that with heavy overclocking, especially on water and LN2 the limiter might engage, and reduce clocks which results in reduced performance. Real-time clock monitoring does not show the changed clocks, so besides the loss in performance it could be difficult to detect that state without additional testing equipment or software support.

I did some testing of this feature in Furmark and recorded card only power consumption over time. As you can see the blue line fluctuates heavily over time which also affects clocks and performance accordingly. Even though we see spikes over 300 W in the graph, the average (represented by the purple line) is clearly below 300 W. It also shows that the system is not flexible enough to adjust power consumption to hit exactly 300 W.

Protection enabled:

Protection disabled:

Na optimizaciji potrošnje se neminovno radilo ali nije sve tako ružičasto kao što se predstavlja.

Iako će se ovaj ili sličan vid eksploatacije kartica verovatno retko koristiti (HPC? CUDA programming?) ipak je dobro videti kako nVidia PR ume da ubedi narod da je "usual power consumption" isto što i TDP