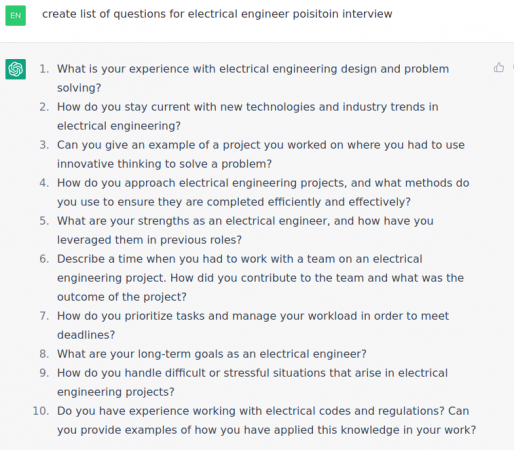

ChatGPT deluje impresivno, na prvi pogled. Ali onda se setis da je to statisticki model koji na jezik gleda kao gomilu nula i jedinica, gde neki nizovi nula i jedinica imaju statisticki vecu sansu da se nadju pored drugih nula i jedinica. I onda se to sve lepo isponderise tako da deluje kao da je "neko" iza tog algoritma, neko ko razume kontekst i nijanse jezika (kao, sa primerom sa pitanjima na intervjuu za elektrotehnicnkog inzenjera, gde je algoritam vrv pronasao tekstove iz svog training seta koji su bili na vrhu Google pretrage, ili ciji su se linkovi najvise serovali na razlicitim web stranama, ili dobili najvise glasova na nekom Reddit threadu, i to sve lepo zajedno ukombinovao i servirao).

Evo na primer njegovog odgovora na dobro staro glupo pitanje "kako da stavis slona u frizider?" (uzmes slona, otvoris frizider, stavis slona u frizider, zatvoris frizider lmao). Ljudsko bice bi vrv odgovorilo ili da je to nemoguce, ili bi pitalo kako da ga stavis u frizider. ChatGPT je prepoznao da prva rec predstavlja zivo bice, to jest divlju zivotinju koja je velk'a a da druga rec ima veze sa ogranicenim prostorom (bilo bi kul da je bar prepoznao da frizider hladi i da ziva bica ne reaguju dobro na hladnocu al mrka kapa) i pronasao obrazac u svom trening setu koji se sveo na to da ziva bica ne reaguju dobro kada su u ogranicenom prostoru, te je i dao takav, generican odgovor koji samo na prvi pogled deluje "inteligentno" a u stvari nema veze s' vezom.

Deep learning algoritmi su neverovatni kada je rec o prepoznavanju obrazaca sa ogranicenim brojem varijabli. Poslusajte recimo epizodu Lex Fridmanovog podcasta sa Demison Hasabisom, suosnivacem DeepMind. Covek je napravio DL algoritam koji je resio jedan od najkompleksnijih problema dansnjice, tkz. foldovanje proteina. Ali, da bi napravio algoritam koji ce to odraditi, morao je da godinama izucava molekularnu biologiju i organsku hemiju da bi ga mogao nahraniti relevantnim podacima i da bi mogao da mu isprogramira pocetne parametre koji imaju smisla. Algoritam je to odradio zato sto je svetlosnim godinama daleko u odnosu na nas kada je rec o prepoznavanju obrazaca izmedju dva ili vise seta podataka koji imaju ogranicen broj varijabli i kombinacija istih varijabli. Na kraju se ispostavilo da je samo alat koji u pravim rukama moze uraditi neverovatne stvari, kao sto je DukeLander napisao:

Programere uposljavas za specificne stvari, gde su ti potrebna specificna resenja. Tu ti AI nece previse pomoci, eventualno malo skratiti programeru vreme i kontrola gresaka.

Drugim recima, ako onaj koji koristi taj alat nema pojma o oblasti i/ili zadatku za koji taj alat koristi, taj alat je beskoristan.

Jos jedan primer. Mnogi DL algoritmi za prepoznavanje fotografija su dizajnirani kao bottom-up sistemi koji krecu od bazicnih stvari (linije, uglovi, itd.) i zatim ih kombinuju u sire obrasce da bi na kraju stvarali gomilu iteracija sa razlicitim kombinacijama obrazaca u svojim black box neuronskim mrezama koje na kraju koriste da daju odgovor da li fotografija prikazuje odredjenu kategoriju (recimo jabuku, ili krusku, ili sta vec).

Ali novija istrazivanja ljudskog vizuelnog sistema sugerisu da nas vizuelni sistem funkcionise na potpuno drugaciji nacin, kao top-down sistem koji "halucinira" nase okruzenje dok signali iz vizuelnog korteksa sluze da "smire" taj top-down sistem (a ne da konstruisu nase vidjenje sveta) i daju mu smernice kako da prilagodi tu "halucinaciju" da lici na ono sto se nalazi ispred nas. Anil Seth to spominje u njegovoj knjizi "Being You" koja govori o njegovoj, naturalistickoj teoriji svesnosti koja se na kraju svodi na to da je svesnost tu da bi nas mozak imao laksu kontrolu nad nasim telom i da bi nas sto duze drzao dalje od entropije (smrti). Veoma zanimljiva naturalisticka teorija svesnosti ali, kao i sve ostale, nemoguce je testirati. Jer nemamo pojma sta je svesnost i kako funkcionise, kao sto je NShappy vise puta rekao. Takodje nemamo pojma ni kako funckionise inteligencija, ali imamo neke pretpostavke o kojima necu pisati jer sam vec napisao roman.

DL algoritmi nemaju ni š od inteligencije, kao ni emocije, ni sire znanje o svetu, ne razumeju razliku izmedju kauzalnosti i korelacije, nemaju pojam o vremenu, kao ni gomilu drugih stvari koje nas cine svesnim i inteligentnim. Odlicni su za uskospecificne zadatke koji sadrze ogranicen broj varijabli, ali su jako losi sa zadacima koji se mogu naci u stvarnom svetu. Zato ih je ultra lako prevariti na testovima prepoznavanja slika (samo ubacite par random piksela i algoritam nece imati pojma o kakvom se objektu radi jer njegovo "prepoznavanje" objekata nema veze sa tim kako neko inteligentno bice prepoznaje objekte).

Zato i najverovatnije necemo nikada imati DL sistem sposoban za potpuno autonomnu voznju. Jer stvaran svet ima neogranicen broj dinamickih varijabli (to jest, varijabli koje evoluiraju kroz vreme) koje se medjusobno mogu kombinovati na neogranicen broj nacina. A posto DL algoritmi nemaju inteligenciju koja moze u momentu reagovati na nepoznate varijable, nikada nece moci da pokriju 100 odsto situacija koje se mogu desiti u stvarnom svetu.

ChatGPT i njegovi naslednici nikada nece moci da oponasaju ljudsku inteligenciju, ili da i sami stvore nesto sto se moze nazvati inteligencijom, ali ce vrv doci blizu. A to ce biti dovoljno za neke kul primene, kao recimo ultra mocan Google Assistant koji ce jednog dana moci da zameni Google pretragu i pruzi korisnicima veoma lak nacin da dodju do smislenih odgovora na vecinu pitanja kao i da nauce maltene sve sto ih zanima.

Ali, da bi dobili pravi vestacku inteligenciju, moracemo da idemo dalje od Deep Learning algoritama. Em su ograniceni em koriste tonu resurasa. Zato su i bili na ledu decenijama, dok nismo dobili ultra mocne GPU-ove. Videcemo ko ce prvi da napravi revoluciju ali sve govori da cemo za tu revoluciju morati da skontamo kako funkcionse inteligencija, ili svesnost, ili oba. A ko zna kada ce se to, i da li ce se uopste, desiti.