P

Precise

Guest

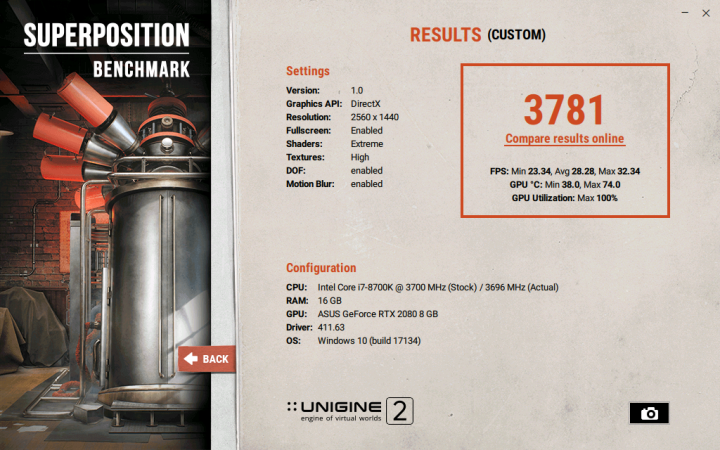

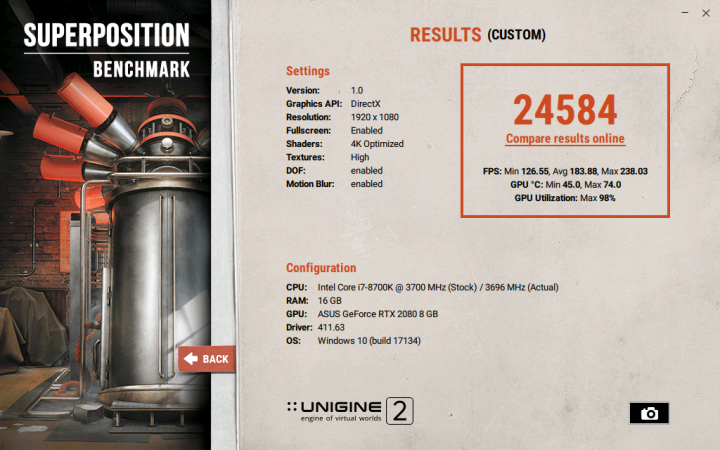

osim ako ne gajis 4k rezoluciju... exactly, sherlock.

u 800x600 i 1050 sabija

Nemoj da preterujes, kao sto rekoh, veci perf je potreban samo za 4K i one koji igraju na 144Hz, a mislim da nije puno tih lovatora, pogotovo u Srbiji, tako da bih zanemario taj zanemarljiv broj korisnika.

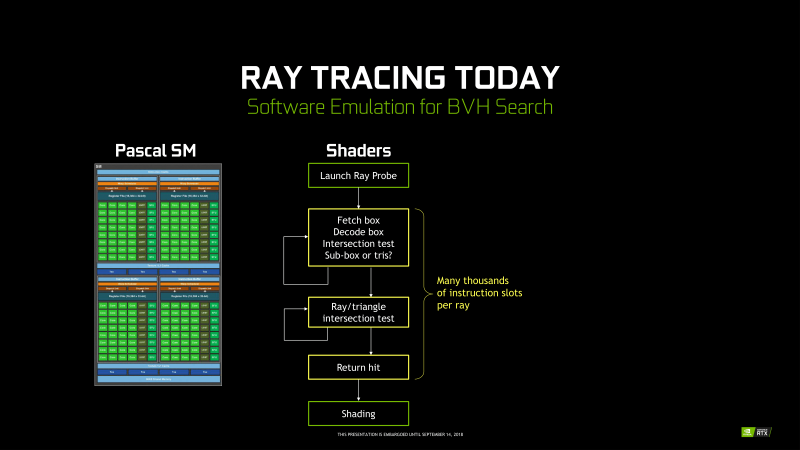

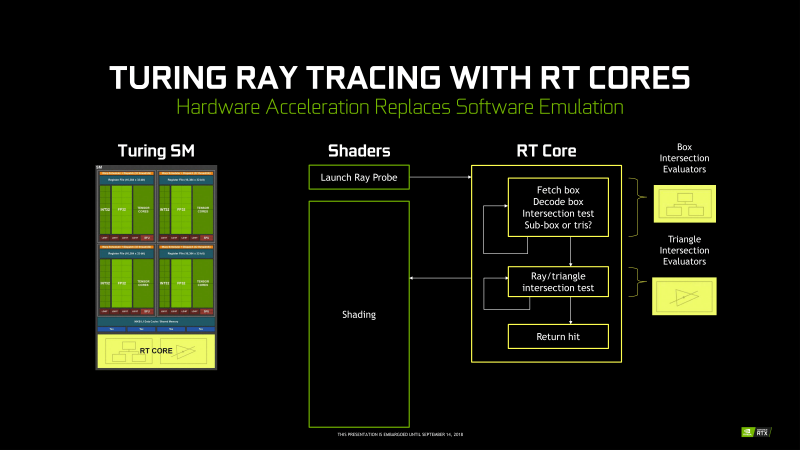

Perf je nebitan za novu generaciju, jer tu pricu je resio Pascal, a Nvidia je uradila ono sto je i trebalo, obzirom da ne treba perfa, fokusirala se na tehnologije, RTX i Deep Learning.